ਆਰਟੀਫ਼ਿਸ਼ੀਅਲ ਇੰਟੈਲੀਜੈਂਸ ਜਾਂ ਏਆਈ | Deepfake

ਡੀਪਫੇਕ ਨਿੱਜੀ ਜੀਵਨ ਤੋਂ ਅੱਗੇ ਵਧ ਕੇ ਹੁਣ ਸਿਆਸੀ ਅਤੇ ਸੰਸਾਰਕ ਸੰਦਰਭਾਂ ਲਈ ਇੱਕ ਗੰਭੀਰ ਖ਼ਤਰਾ ਬਣਦਾ ਜਾ ਰਿਹਾ ਹੈ 21ਵੀਂ ਸਦੀ ’ਚ ਬਨਾਉਟੀ ਬੌਧਿਕਤਾ (ਆਰਟੀਫ਼ਿਸ਼ੀਅਲ ਇੰਟੈਲੀਜੈਂਸ ਜਾਂ ਏਆਈ) ਤਕਨੀਕ ਦੇ ਆਗਮਨ ਨੇ ਜੇਕਰ ਸਹੂਲਤਾਂ ਦੇ ਨਵੇਂ ਰਸਤੇ ਖੋਲ੍ਹੇ ਹਨ ਤਾਂ ਦੁਨੀਆ ਭਰ ’ਚ ਚਿੰਤਾਵਾਂ ਵੀ ਵਧਾ ਦਿੱਤੀਆਂ ਹਨ ਇਸ ਤਕਨੀਕ ਦੀ ਦੁਰਵਰਤੋਂ ਵੱਡੇ ਪੈਮਾਨੇ ’ਤੇ ਸ਼ੁਰੂ ਹੋ ਗਈ ਹੈ, ਏਆਈ ਜ਼ਰੀਏ ਡੀਪਫੇਕ ਵੀਡੀਓ ਬਣਾ ਕੇ ਸੋਸ਼ਲ ਮੀਡੀਆ ’ਤੇ ਵਾਇਰਲ ਕੀਤੀਆਂ ਜਾ ਰਹੀਆਂ ਹਨ ਗਲਤ ਸੂਚਨਾਵਾਂ, ਆਡੀਓ-ਵੀਡੀਓ ਅਤੇ ਤਸਵੀਰਾਂ ਫੈਲਾਉਣ ਵਾਲਿਆਂ ਦੇ ਹੱਥਾਂ ’ਚ ਏਆਈ ਨੇ ਖਤਰਨਾਕ ਹਥਿਆਰ ਫੜ੍ਹਾ ਦਿੱਤਾ ਹੈ, ਜੋ ਰਾਸ਼ਟਰੀ ਸੁਰੱਖਿਆ ਅਤੇ ਸਿਆਸੀ ਮੁੱਦਿਆਂ ਦੇ ਨਾਲ ਨਿੱਜੀ ਛਵ੍ਹੀ ਨੂੰ ਧੁੰਦਲਾ ਕਰਨ ਦਾ ਇਹ ਹਥਿਆਰ ਕਈ ਚਿਤਾਵਾਂ ਨੂੰ ਵਧਾ ਰਿਹਾ ਹੈ ਅਤੇ ਵੱਡੇ ਸੰਕਟ ਦਾ ਸਬੱਬ ਬਣਦਾ ਜਾ ਰਿਹਾ ਹੈ।

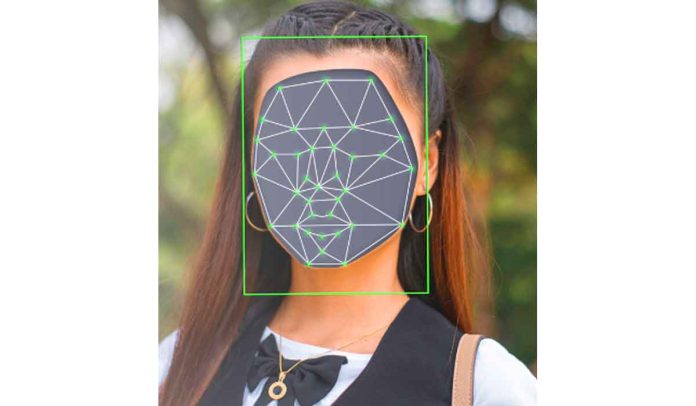

ਡੀਪਫੇਕ ਨੇ ਪ੍ਰਧਾਨ ਮੰਤਰੀ ਮੋਦੀ ਨੂੰ ਵੀ ਨਹੀਂ ਬਖਸ਼ਿਆ ਹੈ, ਉਨ੍ਹਾਂ ਨੂੰ ਵੀ ਪ੍ਰੇਸ਼ਾਨ ਕਰ ਦਿੱਤਾ ਹੈ ਉਨ੍ਹਾਂ ਦੀ ਇੱਕ ਵੀਡੀਓ ਪਿਛਲੇ ਦਿਨੀਂ ਯੂ-ਟਿਊਬ ਸਮੇਤ ਸਾਰੇ ਸੋਸ਼ਲ਼ ਮੀਡੀਆ ਪਲੇਟਫਾਰਮਾਂ ’ਤੇ ਖੂਬ ਚਰਚਿਤ ਹੋਈ ਹੈ, ਇਸ ’ਚ ਉਨ੍ਹਾਂ ਨੂੰ ਗਰਬਾ ਕਰਦੇ ਦਿਖਾਇਆ ਗਿਆ ਹੈ ਇਹ ਪੂਰੀ ਵੀਡੀਓ ਡੀਪਫੇਕ ਨਾਂਅ ਦੀ ਆਰਟੀਫ਼ਿਸ਼ੀਅਲ ਇੰਟੈਲੀਜੈਂਸ ਨਾਲ ਤਿਆਰ ਕੀਤੀ ਗਈ ਹੈ ਇਸ ਤਰ੍ਹਾਂ ਦੇਸ਼ ਅਤੇ ਵਿਦੇਸ਼ ਦੀਆਂ ਕਈ ਹਸਤੀਆਂ ਦੇ ਕਈ ਅਸ਼ਲੀਲ ਅਤੇ ਸਿਆਸੀ ਡੀਪਫੇਕ ਵਿਆਪਕ ਪੱਧਰ ’ਤੇ ਪ੍ਰਸਾਰਿਤ ਹੋ ਰਹੇ ਹਨ ਡੀਪਫੇਕ ਇੱਕ ਅਜਿਹੀ ਤਕਨੀਕ ਹੈ ਜਿਸ ’ਚ ਤੁਸੀਂ ਬਨਾਉਟੀ ਬੌਧਿਕਤਾ ਦੀ ਮੱਦਦ ਅਤੇ ਤਕਨੀਕ ਨਾਲ ਵੀਡੀਓ, ਤਸਵੀਰਾਂ ਤੇ ਆਡੀਓ ’ਚ ਹੇਰਫੇਰ ਕਰ ਸਕਦੇ ਹੋ ਇਸ ਤਕਨੀਕ ਦੀ ਮੱਦਦ ਨਾਲ ਤੁਸੀਂ ਕਿਸੇ ਦੂਜੇ ਵਿਅਕਤੀ ਦੀ ਫੋਟੇ ਜਾਂ ਵੀਡੀਓ ’ਤੇ ਕਿਸੇ ਹੋਰ ਦਾ ਚਿਹਰਾ ਲਾ ਕੇ ਉਸ ਨੂੰ ਪੂਰੀ ਤਰ੍ਹਾਂ ਬਦਲ ਵੀ ਸਕਦੇ ਹੋ। (Deepfake)

ਇਹ ਵੀ ਪੜ੍ਹੋ : ਸਹੀ ਫੈਸਲਾ ਲੈਣ ਦੀ ਜ਼ਰੂਰਤ

ਇੱਕ ਰਿਪੋਰਟ ਅਨੁਸਾਰ ਇਸ ਦਾ ਸਭ ਤੋਂ ਜ਼ਿਆਦਾ ਇਸਤੇਮਾਲ ਲਗਭਗ 96 ਪ੍ਰਤੀਸ਼ਤ ਦੇ ਆਸ-ਪਾਸ ਅਸ਼ਲੀਲ ਸਮੱਗਰੀ ਬਣਾਉਣ ’ਚ ਹੁੰਦਾ ਹੈ ਕੁਝ ਲੋਕ ਇਸ ਦੀ ਵਰਤੋਂ ਆਪਣੇ ਮਰ ਚੁੱਕੇ ਰਿਸ਼ਤੇਦਾਰਾਂ ਦੀਆਂ ਤਸਵੀਰਾਂ ਨੂੰ ਐਨੀਮੇਟ ਕਰਨ ’ਚ ਵੀ ਕਰਦੇ ਹਨ ਪਰ ਹੁਣ ਡੀਪਫੇਕ ਕੰਟੈਂਟ ਦੀ ਵਰਤੋਂ ਦੇਸ਼ ਅਤੇ ਵਿਦੇਸ਼ ਦੀ ਰਾਜਨੀਤੀ ’ਚ ਵੀ ਹੋਣ ਲੱਗੀ ਹੈ ਸਿਆਸੀ ਪਾਰਟੀਆਂ ਆਪਣੇ ਚੋਣ ਪ੍ਰਚਾਰ ’ਚ ਇਸ ਤਕਨੀਕ ਦੀ ਜੰਮ ਕੇ ਵਰਤੋਂ ਕਰ ਰਹੀਆਂ ਹਨ ਆਮ ਆਦਮੀ ਨੂੰ ਗੁੰਮਰਾਹ ਕਰਨ ਅਤੇ ਵੱਡੀਆਂ ਹਸਤੀਆਂ ਦੀ ਛਵ੍ਹੀ ਅਤੇ ਪ੍ਰਤਿਸ਼ਠਾ ਨੂੰ ਧੁੰਦਲਾ ਕਰਨ ’ਚ ਹੁਣ ਇਸ ਤਕਨੀਕ ਦੀ ਵਿਆਪਕ ਵਰਤੋਂ ਹੋਣ ਲੱਗੀ ਹੈ ਪਬਲਿਕ ਪਲੇਟਫਾਰਮਸ ’ਤੇ ਮੌਜੂਦ ਫੋਟੋਜ ਦੀ ਮੱਦਦ ਨਾਲ ਅਸਾਨੀ ਨਾਲ ਡੀਪਫੇਕ ਵੀਡੀਓ ਬਣਾਈ ਜਾ ਸਕਦੀ ਹੈ। (Deepfake)

ਅਜਿਹੇ ਸਮੇਂ ’ਚ ਜਦੋਂ ਕੋਈ ਅਨਟਰੇਂਡ ਵੀ ਆਸਾਨੀ ਨਾਲ ਫਰਜੀ ਵੀਡੀਓ ਬਣਾ ਕੇ ਸੱਚ ਅਤੇ ਝੂਠ ਦਾ ਫਰਕ ਮਿਟਾ ਸਕਦਾ ਹੈ, ਕਿਸੇ ਵੀ ਵੀਡੀਓ ’ਤੇ ਝੱਟ ਭਰੋਸਾ ਨਾ ਕਰੋ ਕਿਉਂਕਿ ਡੀਪਫੇਕ ਵੀਡੀਓ ਨਾਲ ਘਿਰੀ ਵਰਚੁਅਲ ਦੁਨੀਆ ’ਚ ਅੱਖੀਂ ਦੇਖਿਆ ਸਭ ਕੁਝ ਸੱਚ ਨਹੀਂ ਹੁੰਦਾ ਦੇਸ਼-ਵਿਦੇਸ਼ ’ਚ ਕਈ ਪ੍ਰਸਿੱਧ ਹਸਤੀਆਂ ਡੀਪਫੇਕ ਵੀਡੀਓ ਦਾ ਸ਼ਿਕਾਰ ਹੋ ਚੁੱਕੀਆਂ ਹਨ ਕਈ ਵਿਦੇਸ਼ੀ ਹਸਤੀਆਂ ਦੀਆਂ ਵੀ ਡੀਪਫੇਕ ਵੀਡੀਓ ਸਾਹਮਣੇ ਆ ਗਈਆਂ ਹਨ ਯੂਕਰੇਨ ਦੇ ਰਾਸ਼ਟਰਪਤੀ ਵਲਾਦੀਮੀਰ ਜੈਲੇਂਸਕੀ ਦੀ ਡੀਪਫੇਕ ਵੀਡੀਓ ’ਚ ਤਾਂ ਉਹ ਰੂਸ ਨਾਲ ਲੜ ਰਹੀ ਆਪਣੀ ਫੌਜ ਨੂੰ ਸਰੈਂਡਰ ਕਰਨ ਲਈ ਕਹਿ ਰਹੇ ਹਨ ਇਜ਼ਰਾਇਲ-ਹਮਾਸ ਜੰਗ ਦੀਆਂ ਵੀ ਕਈ ਡੀਪਫੇਕ ਵੀਡੀਓ ਸੋਸ਼ਲ ਮੀਡੀਆ ’ਤੇ ਵਾਇਰਲ ਹੋ ਗਈਆਂ ਹਨ। (Deepfake)

ਇਹ ਵੀ ਪੜ੍ਹੋ : ਭੂਚਾਲ ਦੇ ਤੇਜ਼ ਝਟਕੇ, ਲੋਕਾਂ ’ਚ ਦਹਿਸ਼ਤ

ਫ਼ਿਰ ਪ੍ਰਧਾਨ ਮੰਤਰੀ ਨਰਿੰਦਰ ਮੋਦੀ ਨੇ ਵੀ ਡੀਪਫੇਕ ਨੂੰ ਦੇਸ਼ ਲਈ ਸਭ ਤੋਂ ਵੱਡੇ ਖਤਰਿਆਂ ’ਚੋਂ ਇੱਕ ਦੱਸ ਇਸ ਖਿਲਾਫ਼ ਜਨਤਾ ਨੂੰ ਜਾਗਰੂਕ ਅਤੇ ਸਾਵਧਾਨ ਕਰਨ ’ਤੇ ਜ਼ੋਰ ਦਿੱਤਾ ਹੈ ਭਾਰਤ ਲਈ ਇਹ ਵੱਡਾ ਖਤਰਾ ਇਸ ਲਈ ਵੀ ਹੈ ਕਿ ਭਾਰਤ ਵਿਭਿੰਨਤਾ ਵਾਲਾ ਦੇਸ਼ ਹੈ, ਇੱਥੋਂ ਦੀ ਜਨਤਾ ਛੋਟੀਆਂ-ਛੋਟੀਆਂ ਗੱਲਾਂ ’ਤੇ ਭਾਵੁਕ ਅਤੇ ਭੜਕ ਜਾਂਦੀ ਹੈ ਅਸਲੀ ਅਤੇ ਨਕਲੀ ਭਾਵ ਡੀਪਫੇਕ ਦਾ ਪਤਾ ਲਾਉਣ ਲਈ ਚੌਕਸੀ ਅਤੇ ਸਾਵਧਾਨੀ ਵਰਤਣ ਦੀ ਉਮੀਦ ਹੈ ਜੇਕਰ ਵੀਡੀਓ ’ਚ ਅੱਖ ਅਤੇ ਨੱਕ ਕਿਤੇ ਹੋਰ ਜਾ ਰਿਹਾ ਹੈ ਜਾਂ ਵੀਡੀਓ ’ਚ ਅੱਖਾਂ ਨਹੀਂ ਝਮੱਕੀਆਂ ਗਈਆਂ ਤਾਂ ਸਮਝ ਜਾਓ ਇਹ ਡੀਪਫੇਕ ਕੰਟੈਂਟ ਹੈ ਕੰਟੈਂਟ ਦੀ ਕਲਰਿੰਗ ਨੂੰ ਵੀ ਦੇਖ ਕੇ ਪਤਾ ਲੱਗ ਸਕਦਾ ਹੈ ਕਿ ਤਸਵੀਰ ਜਾਂ ਵੀਡੀਓ ’ਚ ਛੇੜਛਾੜ ਹੋਈ ਹੈ। (Deepfake)

ਕਈ ਚਰਚਿਤ ਮਹਿਲਾ ਹਸਤੀਆਂ ਅਤੇ ਸਿਨੇ ਕਲਾਕਾਰਾਂ ਦੇ ਚਿਹਰੇ ਡੀਪਫੇਕ ਟੈਕ ਦੀ ਮੱਦਦ ਨਾਲ ਗਲਤ ਵੀਡੀਓ ’ਤੇ ਲਾ ਕੇ ਉਨ੍ਹਾਂ ਨੂੰ ਆਨਲਾਈਨ ਸ਼ੇਅਰ ਕੀਤਾ ਜਾ ਰਿਹਾ ਹੈ ਪਾਪੁਲਰ ਅਮਰੀਕਨ ਅਡਲਟ ਸਾਈਟ ਦੀ ਟੇ੍ਰਡਿੰਗ ਟੈਗਸ ਰਿਪੋਰਟ ਦਿਖਾਉਂਦੀ ਹੈ ਕਿ ਅਜਿਹੀਆਂ ਵੀਡੀਓ ਪਿਛਲੇ ਕੁਝ ਮਹੀਨਿਆਂ ’ਚ ਤੇਜ਼ੀ ਨਾਲ ਚਰਚਿਤ ਹੋਈਆਂ ਹਨ ਅਤੇ ਇਨ੍ਹਾਂ ਨੂੰ ਵਿਆਪਕ ਤੌਰ ’ਤੇ ਸਰਚ ਕੀਤਾ ਜਾ ਰਿਹਾ ਹੈ ਜਾਂ ਦੇਖਿਆ ਜਾ ਰਿਹਾ ਹੈ ਮਾਹਿਰਾਂ ਦਾ ਮੰਨਣਾ ਹੈ ਕਿ ਜਿਵੇਂ-ਜਿਵੇਂ ਇਹ ਟੈਕਨਾਲੋਜੀ ਪ੍ਰਸਿੱਧ ਹੋਵੇਗੀ, ਇਸ ਦੀ ਦੁਰਵਰਤੋਂ ਅਤੇ ਅਜਿਹੇ ਕ੍ਰਾਈਮ ਵੀ ਵਧਦੇ ਜਾਣਗੇ ਬਨਾਉਟੀ ਬੁੱਧੀ, ਕੰਪਿਊਟਰ ਵਿਗਿਆਨ ਦੀ ਇੱਕ ਸ਼ਾਖਾ ਹੈ ਜੋ ਮਸ਼ੀਨਾਂ ਅਤੇ ਸਾਫਟਵੇਅਰ ਨੂੰ ਬੁੱਧੀ ਨਾਲ ਵਿਕਸਿਤ ਕਰਦਾ ਹੈ 1955 ’ਚ ਜਾਨ ਮੈਕਾਰਥੀ ਨੇ ਇਸ ਨੂੰ ਬਨਾਉਟੀ ਬੁੱਧੀ ਦਾ ਨਾਂਅ ਦਿੱਤਾ। (Deepfake)

ਉਸ ਨੂੰ ‘ਵਿਗਿਆਨ ਅਤੇ ਇੰਜੀਨੀਅਰਿੰਗ ਦੇ ਬੁੱਧੀਮਾਨ ਮਸ਼ੀਨਾਂ ਬਣਾਉਣ ਦੇ’ ਦੇ ਰੂਪ ’ਚ ਪਰਿਭਾਸ਼ਿਤ ਕੀਤਾ ਬਨਾਉਟੀ ਬੁੱਧੀ ਰਿਸਰਚ ਦੇ ਟੀਚਿਆਂ ’ਚ ਤਰਕ, ਗਿਆਨ ਦੀ ਯੋਜਨਾ, ਸਿੱਖਣ, ਧਾਰਨਾ ਤੇ ਵਸਤੂਆਂ ’ਚ ਹੇਰਫੇਰ ਕਰਨ ਦੀ ਸਮਰੱਥਾ ਆਦਿ ਸ਼ਾਮਲ ਹਨ ਵਰਤਮਾਨ ’ਚ, ਇਸ ਟੀਚੇ ਤੱਕ ਪਹੁੰਚਣ ਲਈ ਅੰਕੜਾ ਵਿਧੀਆਂ, ਕੰਪਿਊਟੈਸ਼ਨਲ ਬੁੱਧੀ ਅਤੇ ਪਾਰੰਪਰਿਕ ਖੁਫ਼ੀਆ ਵਿਧੀਆਂ ਸ਼ਾਮਲ ਹਨ ਬਨਾਉਣੀ ਬੁੱਧੀ ਦਾ ਦਾਅਵਾ ਐਨਾ ਹੈ ਕਿ ਮਨੁੱਖ ਦੀ ਬੁੱਧੀ ਦਾ ਇੱਕ ਕੇਂਦਰੀ ਸੰੱਪਤੀ ਇੱਕ ਮਸ਼ੀਨ ਦੁਆਰਾ ਪਾਲਣ ਕਰ ਸਕਦਾ ਹੈ ਬਿਜਲੀ ਦੇ ਬੱਲਬ ਅਤੇ ਮੂਵੀ ਕੈਮਰੇ ਦੇ ਖੋਜਕਰਤਾ ਥਾਮਮ ਅਲਵਾ ਐਡੀਸਨ ਨੇ ਕਿਹਾ ਸੀ ਕਿ ਹਰ ਨਵੀਂ ਤਕਨੀਕ ਸੁਵਿਧਾਵਾਂ ਦੇ ਨਾਲ ਕੁਝ ਨਕਾਰਾਤਮਕ ਪਹਿਲੂ ਵੀ ਲਿਆਉਂਦੀ ਹੈ। (Deepfake)

ਨਿੱਤ ਨਵੀਆਂ ਤਕਨੀਕ ਦੇ ਦੌਰ ’ਚੋਂ ਲੰਘ ਰਹੀ ਦੁਨੀਆ ’ਚ ਉਨ੍ਹਾਂ ਦਾ ਕਥਨ ਪ੍ਰਾਸੰਗਿਕ ਬਣਿਆ ਹੋਇਆ ਹੈ ਬਨਾਉਟੀ ਬੌਧਿਕਤਾ ਤਕਨੀਕ ਦੇ ਆਉਣ ਨੇ ਜੇਕਰ ਸੁਵਿਧਾਵਾਂ ਦੇ ਨਵੇਂ ਰਸਤੇ ਖੋਲ੍ਹੇ ਹਨ ਤਾਂ ਦੁਨੀਆ ਭਾਰ ’ਚ ਚਿੰਤਾਵਾਂ ਵੀ ਵਧਾ ਦਿੱਤੀਆਂ ਹਨ ਇਸ ਤਕਨੀਕ ਦੀ ਦੁਰਵਰਤੋਂ ਵੱਡੇ ਪੈਮਾਨੇ ’ਤੇ ਸ਼ੁਰੂ ਹੋ ਗਈ ਹੈ ਕਿਸੇ ਵੀ ਗੱਲ ਜਾਂ ਘਟਨਾ ਦੇ ਸੱਚ ਹੋਣ ਦਾ ਸਭ ਤੋਂ ਵੱਡਾ ਸਬੂਤ ਉਸ ਦੀ ਕਿਸੇ ਵੀਡੀਓ ਨੂੰ ਮੰਨਿਆ ਜਾਂਦਾ ਰਿਹਾ ਹੈ ਪਰ ਹੁਣ ਚੀਜ਼ਾਂ ਬਦਲ ਗਈਆਂ ਹਨ ਅੱਖੀਂ ਦੇਖੀ ’ਤੇ ਅੇਤੇ ਕਿਸੇ ਵੀ ਤਰ੍ਹਾਂ ਦੇ ਡਿਜ਼ੀਟਲ ਫੋਟੋ ਜਾਂ ਵੀਡੀਓ ’ਤੇ ਭਰੋਸਾ ਨਹੀਂ ਕੀਤਾ ਜਾ ਸਕਦਾ ਡੀਪਫੇਕ ਟੈਕਨਾਲੋਜੀ ਦੀ ਮੱਦਦ ਨਾਲ ਅਜਿਹੀਆਂ ਵੀਡੀਓ ਬਣਾਈਆਂ ਜਾ ਸਕਦੀਆਂ ਹਨ ਕਿ ਵੱਡੇ-ਵੱਡੇ ਐਕਸਪਰਟਸ ਵੀ ਧੋਖਾ ਖਾ ਜਾਣ ਆਮ ਇੰਟਰਨੈਟ ਯੂਜਰ ਸ਼ਾਇਦ ਹੀ ਸਮਝ ਸਕੇ। (Deepfake)

ਭਾਰਤ ਸਰਕਾਰ ਇਸ ਮੁੱਦੇ ’ਤੇ ਇਸ ਦੇ ਖ਼ਤਰੇ ਨੂੰ ਦੇਖਦਿਆਂ ਗੰਭੀਰ ਹੈ

ਕਿ ਵੀਡੀਓ ਡੀਪਫੇਕ ਹੈ ਅਤੇ ਉਸ ’ਚ ਦਿਸਣ ਵਾਲਾ ਸ਼ਖਸ ਕੋਈ ਹੋਰ ਹੈ ਇਹ ਟੈਕਨਾਲੋਜੀ ਵੀਡੀਓਜ਼ ਨਾਲ ਬਿਲਕੁਲ ਉਂਜ ਹੀ ਕੰਮ ਕਰਦੀ ਹੈ, ਜਿਵੇਂ ਫੋਟੋ ਲਈ ਫੋਟੋਸ਼ਾਪ ਕਰਦਾ ਹੈ ਭਾਰਤ ’ਚ ਡੀਪਫੇਕ ਤਕਨੀਕ ਦੀ ਦੁਰਵਰਤੋ ਰੋਕਣ ਅਤੇ ਫਰਜ਼ੀ ਵੀਡੀਓ ਦੀ ਪਛਾਣ ਲਈ ਬਿਹਤਰ ਤਕਨੀਕ ਵਿਕਸਿਤ ਕਰਨ ਦੀ ਜ਼ਰੂਰਤ ਹੈ ਚਿੰਤਾ ਦੀ ਗੱਲ ਹੈ ਕਿ ਸੋਸ਼ਲ ਮੀਡੀਆ ਮੰਚਾਂ ਤੇ ਟੈਕ ਕੰਪਨੀਆਂ ਨੇ ਡੀਪਫੇਕ ਵੀਡੀਓ ’ਤੇ ਰੋਕ ਲਈ ਕੋਈ ਵੱਡੀ ਪਹਿਲ ਨਹੀਂ ਕੀਤੀ ਹੈ ਪਰ ਭਾਰਤ ਸਰਕਾਰ ਇਸ ਮੁੱਦੇ ’ਤੇ ਇਸ ਦੇ ਖ਼ਤਰੇ ਨੂੰ ਦੇਖਦਿਆਂ ਗੰਭੀਰ ਹੈ ਸਰਕਾਰ ਇੰਟਰਨੈਟ ਇਸਤੇਮਾਲ ਕਰਨ ਵਾਲੇ ਸਾਰੇ ਡਿਜ਼ੀਟਲ ਨਾਗਰਿਕਾਂ ਦੀ ਸੁਰੱਖਿਆ ਅਤੇ ਭਰੋਸੇ ਨੂੰ ਯਕੀਨੀ ਕਰਨ ਲਈ ਵਚਨਬੱਧ ਹੈ ਸਰਕਾਰ ਨੇ ਸੋਸ਼ਲ ਮੀਡੀਆ ਕੰਪਨੀਆਂ ਨੂੰ ਗਲਤ ਸੂਚਨਾਵਾਂ, ਡੀਪਫੇਕ ਅਤੇ ਲੋੜੀਂਦੀ ਸਮੱਗਰੀ ਦੀ ਪਛਾਣ ਕਰਕੇ 36 ਘੰਟੇ ਅੰਦਰ ਉਨ੍ਹਾਂ ਨੂੰ ਹਟਾਉਣ ਦੇ ਨਿਰਦੇਸ਼ ਦਿੱਤੇ ਜਾ ਚੁੱਕੇ ਹਨ। (Deepfake)

ਸੂਚਨਾ ਤਕਨੀਕੀ ਮੰਤਰੀ ਅਸ਼ਵਨੀ ਵੈਸ਼ਣਵ ਨੇ ਸਾਫ਼ ਕਹਿ ਦਿੱਤਾ ਕਿ ਸੋਸ਼ਲ਼ ਮੀਡੀਆ ਪਲੇਟਫਾਰਮ ਜੇਕਰ ਡੀਪਫੇਕ ਕੰਟੈਂਟ ਨੂੰ ਹਟਾਉਣ ਲਈ ਲੋੜੀਂਦੇ ਕਦਮ ਨਹੀਂ ਚੁੱਕਦੇ ਹਨ ਤਾਂ ਉਨ੍ਹਾਂ ਨੂੰ ਮਿਲਣ ਵਾਲੀ ਸੁਰੱਖਿਆ ਨੂੰ ਵਾਪਸ ਲੈ ਲਿਆ ਜਾਵੇਗਾ ਕਈ ਦੇਸ਼ਾਂ ਦੀਆਂ ਸਰਕਾਰਾਂ ਡੀਪਫੇਕ ਦੇ ਨਿਯਮਾਂ ਦੀ ਤਿਆਰੀ ’ਚ ਹਨ ਕੁਝ ਅਮਰੀਕੀ ਰਾਜਾਂ ’ਚ ਬਤੌਰ ਸਹਿਮਤੀ ਡੀਪਫੇਕ ਬਣਾਉਣ ਨੂੰ ਅਪਰਾਧ ਐਲਾਨ ਕੀਤਾ ਜਾ ਚੁੱਕਾ ਹੈ ਯੂਰਪੀ ਦੇਸ਼ਾਂ ’ਚ ਵੀ ਕਾਨੂੰਨ ਬਣਾਉਣ ਦੀ ਤਿਆਰੀ ਚੱਲ ਰਹੀ ਹੈ ਸਿਰਫ ਕਾਨੂੰਨ ਬਣਾਉਣ ਨਾਲ ਸਮੱਸਿਆ ’ਤੇ ਪਾਰ ਪਾਉਣਾ ਸ਼ੱਕੀ ਹੈ ਜ਼ਰੂਰਤ ਅਜਿਹੇ ਤੰਤਰ ਦੀ ਹੈ, ਜੋ ਡੀਪਫੇਕ ਦੀ ਸਮੁੱਚੀ ਨਿਗਰਾਨੀ ਰੱਖ ਬੇਲੋੜੀ ਸਮੱਗਰੀ ਫੈਲਾਉਣ ਦੇ ਸਾਰੇ ਰਸਤੇ ਬੰਦ ਰੱਖੇ।